SAP và Databricks hợp tác: Nâng tầm AI với Business Data Cloud

SAP Tích Hợp Databricks: Nâng Cao Khả Năng AI Với Business Data Cloud Mới

Ngày 13 tháng 2 năm 2025

Logo Databricks

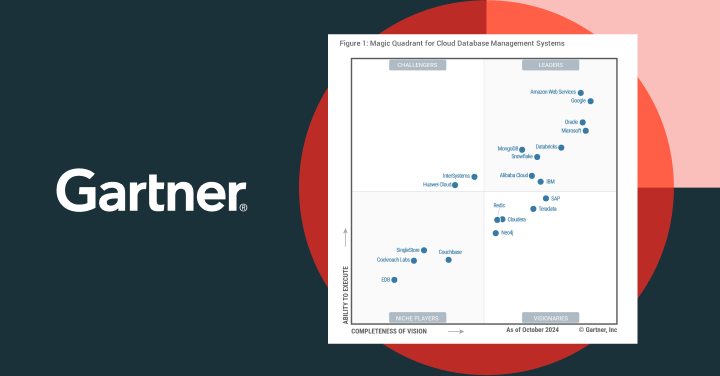

Gartner Magic Quadrant

Giới Thiệu Về Sự Hợp Tác Giữa SAP và Databricks

Gã khổng lồ phần mềm Đức SAP đang nâng cao tiêu chuẩn về dữ liệu để hỗ trợ các trường hợp sử dụng AI thế hệ mới. Công ty gần đây đã giới thiệu Business Data Cloud (BDC), một sản phẩm SaaS mới áp dụng kiến trúc lakehouse để giúp các nhóm làm giàu dữ liệu hệ sinh thái SAP của họ bằng các tài sản dữ liệu bên ngoài từ các hệ thống nguồn khác nhau và thúc đẩy giá trị dài hạn. Sự hợp tác chiến lược này hứa hẹn sẽ thay đổi cách các doanh nghiệp quản lý và tận dụng dữ liệu của mình.

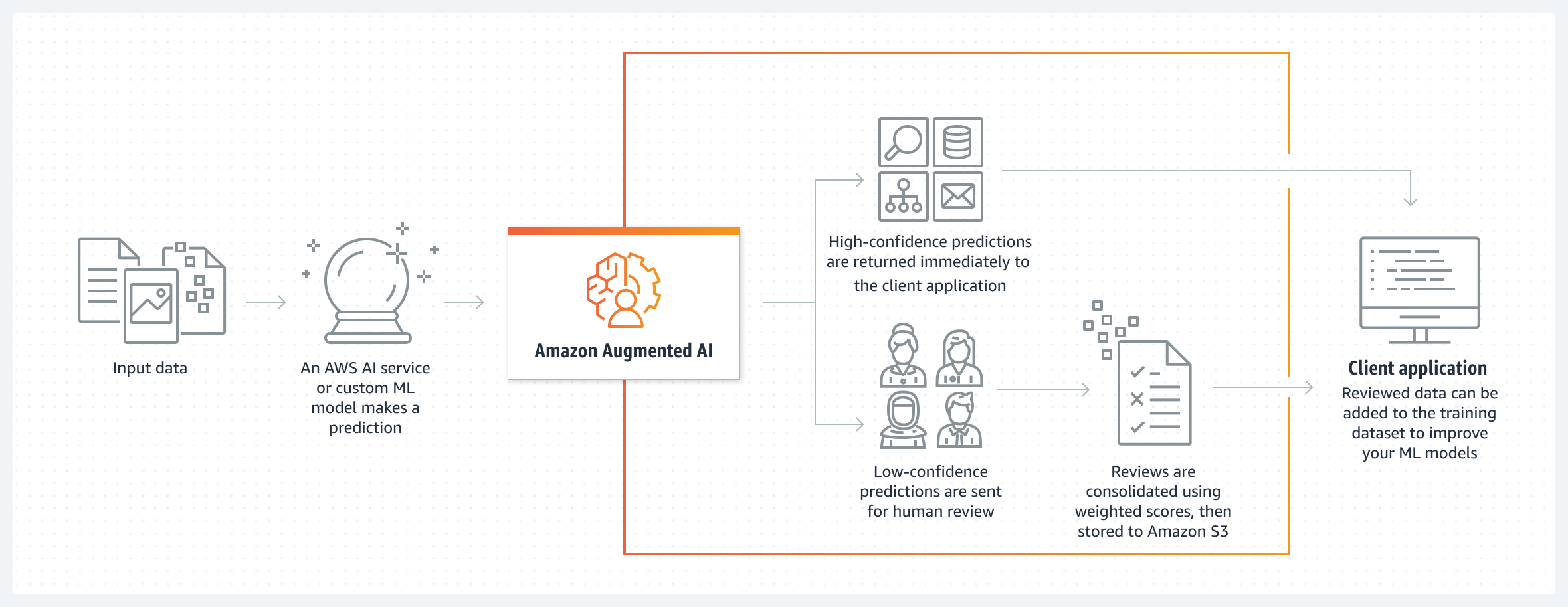

Sản phẩm này là kết quả của sự hợp tác mang tính bước ngoặt với Databricks, một công ty hàng đầu trong lĩnh vực hệ sinh thái dữ liệu. Về cơ bản, SAP BDC tích hợp nguyên bản các khả năng và dữ liệu từ nền tảng trí tuệ dữ liệu của Databricks. Điều này loại bỏ nhu cầu tạo và duy trì các pipeline phức tạp, đồng thời tạo ra một nền tảng dữ liệu hài hòa cho các tác nhân AI tiên tiến và khối lượng công việc phân tích.

Big Book of Data Warehousing and BI

Một số doanh nghiệp, bao gồm Henkel, đang sử dụng BDC để cung cấp năng lượng cho các dự án AI của họ. Bản thân SAP đang sử dụng BDC được làm phong phú để cung cấp năng lượng cho một kỷ nguyên mới của Joule agents tập trung vào các lĩnh vực cụ thể như tài chính, dịch vụ và bán hàng. Sự phát triển này khiến SAP trở thành một người chơi đáng chú ý khác, giống như Microsoft và Salesforce, củng cố nền tảng dữ liệu của mình để đặt nền móng cho AI.

Nền Tảng Dữ Liệu Được Cải Tiến Của SAP

Trong những năm qua, SAP đã khẳng định mình là một trong những công ty hàng đầu trong lĩnh vực hoạch định nguồn lực doanh nghiệp (ERP) với S4/HANA cloud và một số ứng dụng quan trọng cho tài chính, chuỗi cung ứng và quản lý vốn nhân lực. Các ứng dụng này tạo ra dữ liệu quy mô petabyte với bối cảnh kinh doanh và đã cung cấp năng lượng cho giá trị AI và phân tích cho các nhóm, thông qua nền tảng công nghệ kinh doanh (BTP) của công ty.

Cho đến nay, SAP BTP đã có một datasphere cho phép các doanh nghiệp kết nối dữ liệu từ SAP với thông tin từ các hệ thống không phải của SAP và cuối cùng liên kết nó với SAP analytics cloud và các công cụ nội bộ khác cho các ứng dụng hạ nguồn. Giờ đây, công ty đang phát triển trải nghiệm này thành BDC thống nhất, được cung cấp nguyên bản bởi Databricks.

SAP Business Data Cloud Mang Lại Điều Gì?

Điều này có nghĩa là SAP đang áp dụng kiến trúc lakehouse, tạo ra một nền tảng thống nhất kết hợp tất cả các sản phẩm dữ liệu SAP – từ dữ liệu tài chính, chi tiêu và chuỗi cung ứng trong SAP S/4HANA và SAP Ariba, đến dữ liệu học tập và tài năng trong SAP SuccessFactors – với dữ liệu có cấu trúc và phi cấu trúc từ các hệ thống quan trọng khác nhau, được lưu trữ trong Databricks.

Databricks OG Universal

Khi dữ liệu được thống nhất (thông qua chia sẻ hai chiều không sao chép), SAP BDC có thể tận dụng các khả năng cụ thể của Databricks cho các khối lượng công việc như kho dữ liệu, kỹ thuật dữ liệu và AI, tất cả đều được quản lý bởi danh mục hợp nhất Databricks.

Chúng tôi lấy tất cả các sản phẩm dữ liệu khác nhau này, được cung cấp và quản lý bởi SAP… và chúng tôi sẽ duy trì chúng vào lakehouse của SAP business data cloud, trong một mô hình dữ liệu hài hòa, Irfan Khan, chủ tịch và CPO cho dữ liệu và phân tích của SAP, nói với VentureBeat. Lakehouse này sẽ có các khả năng Databricks để người dùng xây dựng dựa trên.

Trước đây, Khan nói, những người dùng có phần lớn dữ liệu của họ trong Databricks và dữ liệu SAP trong S4 hoặc BW phải xây dựng và quản lý các pipeline phức tạp và sao chép tất cả các tài sản dữ liệu vào nền tảng SAP trong khi xây dựng lại toàn bộ ngữ nghĩa và mô hình dữ liệu cốt lõi cùng một lúc. Cách tiếp cận này tốn thời gian và yêu cầu họ phải cập nhật các pipeline của mình với dữ liệu thay đổi. Tuy nhiên, với tích hợp gốc của Databricks, người dùng có quyền truy cập vào mọi thứ ở một nơi và có thể trực tiếp thực hiện kỹ thuật dữ liệu, khoa học dữ liệu và các tác vụ khác trên BDC.

Trong Datasphere, bạn đã có một phương tiện để làm một điều tương tự, nhưng tất cả đều là các sản phẩm dữ liệu do khách hàng quản lý, Khan giải thích. Vì vậy, bạn phải vào nền tảng dữ liệu, chọn nguồn dữ liệu và xây dựng các pipeline dữ liệu. Sau đó, bạn phải tìm ra những gì cần sao chép. Ở đây, tất cả đều do SAP quản lý.

Ý Nghĩa Của Sự Hợp Tác Này Đối Với Doanh Nghiệp

Về cốt lõi, sản phẩm được hỗ trợ bởi Databricks này cung cấp cho các nhóm một cách nhanh hơn, đơn giản hơn để thống nhất và huy động các tài sản dữ liệu kinh doanh của họ bị khóa trong môi trường SAP và Databricks.

Dữ liệu kết hợp, được tăng cường về mặt ngữ nghĩa sẽ mở đường cho việc xây dựng các ứng dụng AI thế hệ tiếp theo nhằm vào các trường hợp sử dụng khác nhau. Ví dụ: một nhóm có thể sử dụng các khả năng AI Mosaic của Databricks để phát triển các tác nhân AI cụ thể theo miền có thể sử dụng bối cảnh từ dữ liệu kinh doanh của SAP cũng như dữ liệu cụ thể của Databricks bên ngoài để tự động hóa một số chức năng quản lý vốn nhân lực hoặc chuỗi cung ứng.

Đáng chú ý, bản thân SAP đang khai thác nền tảng dữ liệu nâng cao này để cung cấp năng lượng cho các tác nhân Joule sẵn sàng sử dụng nhằm tự động hóa các tác vụ và tăng tốc quy trình làm việc trên các chức năng bán hàng, dịch vụ và tài chính. Các tác nhân này hiểu sâu sắc các quy trình đầu cuối và cộng tác để giải quyết các vấn đề kinh doanh phức tạp.

Ngoài ra, BDC sẽ có khả năng ứng dụng thông tin chi tiết, cho phép người dùng kết nối các sản phẩm dữ liệu và mô hình AI của họ với dữ liệu thời gian thực bên ngoài để cung cấp phân tích và lập kế hoạch nâng cao trên các chức năng kinh doanh.

Thêm Đối Tác Dữ Liệu Sắp Ra Mắt

Mặc dù quan hệ đối tác nhấn mạnh một động thái lớn cho cả Databricks và SAP, nhưng điều quan trọng cần lưu ý là công ty dữ liệu do Ali Ghodsi dẫn đầu sẽ không phải là công ty duy nhất củng cố BDC.

Theo Khan, chia sẻ dữ liệu và tính mở của hệ sinh thái là các nguyên tắc thiết kế đầu tiên của công ty – và chúng sẽ mở rộng sang các nền tảng dữ liệu khác thông qua các khả năng kết nối đối tác của họ. Điều này có nghĩa là người dùng doanh nghiệp sẽ có thể chọn nền tảng họ thích (hoặc bị khóa vào) và chia sẻ dữ liệu hai chiều cho các trường hợp sử dụng được nhắm mục tiêu.

Databricks OG Universal 1

Tóm Tắt và Kết Luận

Sự hợp tác giữa SAP và Databricks để tạo ra Business Data Cloud là một bước tiến lớn trong việc tích hợp và quản lý dữ liệu cho doanh nghiệp. Bằng cách tận dụng kiến trúc lakehouse và các khả năng AI tiên tiến, BDC hứa hẹn sẽ giúp các doanh nghiệp khai thác tối đa giá trị từ dữ liệu của mình, đồng thời đơn giản hóa quy trình làm việc và tăng cường khả năng cạnh tranh trên thị trường. Đây là một xu hướng quan trọng trong lĩnh vực công nghệ thông tin, và chúng ta có thể kỳ vọng sẽ thấy nhiều sự hợp tác tương tự trong tương lai.

Các Câu Hỏi Thường Gặp (FAQ)

Business Data Cloud (BDC) là gì?

BDC là một sản phẩm SaaS mới của SAP, được xây dựng trên kiến trúc lakehouse, cho phép các doanh nghiệp làm giàu dữ liệu SAP của họ bằng các tài sản dữ liệu bên ngoài từ các hệ thống nguồn khác nhau.

Lợi ích của việc sử dụng SAP BDC là gì?

BDC giúp đơn giản hóa quy trình quản lý dữ liệu, tăng cường khả năng AI, và cung cấp một nền tảng dữ liệu hài hòa cho các tác nhân AI tiên tiến và khối lượng công việc phân tích.

Những doanh nghiệp nào đang sử dụng SAP BDC?

Một số doanh nghiệp, bao gồm Henkel, đang sử dụng BDC để cung cấp năng lượng cho các dự án AI của họ.