Google ra mắt Gemini 2.0 Pro, Flash-Lite và kết nối mô hình suy luận Flash Thinking với YouTube, Maps và Search!

Hôm nay, công ty thông báo</a > về việc phát hành chung Gemini 2.0 Flash, giới thiệu Gemini 2.0 Flash-Lite và phiên bản thử nghiệm của Gemini 2.0 Pro.

Các mô hình này, được thiết kế để hỗ trợ các nhà phát triển và doanh nghiệp, hiện có thể truy cập thông qua Google AI Studio và Vertex AI, với Flash-Lite ở bản xem trước công khai và Pro có sẵn để thử nghiệm sớm.

“Tất cả các mô hình này sẽ có tính năng nhập đa phương thức với đầu ra văn bản khi phát hành, với nhiều phương thức hơn sẵn sàng cho việc phát hành chung trong những tháng tới,” Koray Kavukcuoglu, giám đốc công nghệ của Google DeepMind, đã viết trong bài đăng trên blog thông báo</a > của công ty — thể hiện một lợi thế mà Google đang mang lại, ngay cả khi các đối thủ cạnh tranh như DeepSeek</a > và OpenAI</a > tiếp tục ra mắt các đối thủ mạnh mẽ.

Google phát huy thế mạnh đa phương thức của mình

Cả DeepSeek R1 và mô hình o3-mini mới của OpenAI</a > đều không thể chấp nhận đầu vào đa phương thức, tức là hình ảnh và tải lên tệp hoặc tệp đính kèm.

Mặc dù DeepSeek R1 có thể chấp nhận chúng trên trang web và ứng dụng di động của mình, nhưng nó thực hiện nhận dạng ký tự quang học (OCR), một công nghệ đã hơn 60 năm tuổi, để chỉ trích xuất văn bản từ các tải lên này — không thực sự hiểu hoặc phân tích bất kỳ tính năng nào khác có trong đó.

Tuy nhiên, cả hai đều là một loại mô hình “lý luận” mới, cố tình dành nhiều thời gian hơn để suy nghĩ kỹ về các câu trả lời và suy ngẫm về “chuỗi suy nghĩ” và tính chính xác của các phản hồi của chúng. Điều đó trái ngược với các LLM điển hình như dòng Gemini 2.0 pro, vì vậy việc so sánh giữa Gemini 2.0 và DeepSeek R1 và OpenAI o3 hơi giống như so sánh táo với cam.

Nhưng cũng có một số tin tức về mặt lý luận ngày hôm nay từ Google: Giám đốc điều hành Google Sundar Pichai đã lên mạng xã hội X</a > để tuyên bố rằng ứng dụng di động Google Gemini</a > dành cho iOS và Android đã được cập nhật với mô hình lý luận đối thủ của riêng Google, Gemini 2.0 Flash Thinking, và mô hình này có thể được kết nối với các dịch vụ nổi tiếng hiện có của Google là Google Maps, YouTube và Google Search, cho phép một loạt các nghiên cứu và tương tác được hỗ trợ bởi AI hoàn toàn mới mà đơn giản là không thể so sánh được với những kẻ mới nổi không có các dịch vụ như DeepSeek và OpenAI.

Tôi đã thử nhanh nó trên ứng dụng Google Gemini iOS trên iPhone của mình trong khi viết bài này và nó rất ấn tượng dựa trên các truy vấn ban đầu của tôi, suy nghĩ về những điểm chung của 10 video YouTube phổ biến nhất trong tháng trước và cũng cung cấp cho tôi một bảng các văn phòng bác sĩ gần đó và giờ mở/đóng cửa, tất cả chỉ trong vài giây.

Gemini 2.0 Flash đi vào phát hành chung

Mô hình Gemini 2.0 Flash, ban đầu được ra mắt dưới dạng phiên bản thử nghiệm vào tháng 12</a >, hiện đã sẵn sàng để sản xuất.

Được thiết kế cho các ứng dụng AI hiệu quả cao, nó cung cấp các phản hồi có độ trễ thấp và hỗ trợ lý luận đa phương thức quy mô lớn.

Một lợi ích lớn so với đối thủ cạnh tranh là ở cửa sổ ngữ cảnh của nó hoặc số lượng mã thông báo mà người dùng có thể thêm vào dưới dạng lời nhắc và nhận lại trong một tương tác qua lại với chatbot hoặc giao diện lập trình ứng dụng được hỗ trợ bởi LLM.

Trong khi nhiều mô hình hàng đầu như o3-mini mới của OpenAI ra mắt vào tuần trước chỉ hỗ trợ 200.000 mã thông báo trở xuống — tương đương với một cuốn tiểu thuyết có mật độ thông tin khoảng 400-500 trang — Gemini 2.0 Flash hỗ trợ 1 triệu, nghĩa là nó có khả năng xử lý một lượng lớn thông tin, khiến nó đặc biệt hữu ích cho các tác vụ tần suất cao và quy mô lớn.

Gemini 2.0 Flash-Lite xuất hiện để uốn cong đường cong chi phí xuống mức thấp nhất từ trước đến nay

Trong khi đó, Gemini 2.0 Flash-Lite là một mô hình ngôn ngữ lớn hoàn toàn mới nhằm cung cấp một giải pháp AI hiệu quả về chi phí mà không ảnh hưởng đến chất lượng.

Google DeepMind tuyên bố rằng Flash-Lite vượt trội hơn người tiền nhiệm (số lượng tham số lớn hơn) kích thước đầy đủ của nó, Gemini 1.5 Flash, trên các điểm chuẩn của bên thứ ba như MMLU Pro (77,6% so với 67,3%) và lập trình Bird SQL (57,4% so với 45,6%), đồng thời duy trì cùng một mức giá và tốc độ.

Nó cũng hỗ trợ đầu vào đa phương thức và có cửa sổ ngữ cảnh 1 triệu mã thông báo, tương tự như mô hình Flash đầy đủ.

Hiện tại, Flash-Lite có sẵn ở bản xem trước công khai thông qua Google AI Studio và Vertex AI, với tính khả dụng chung dự kiến trong những tuần tới.

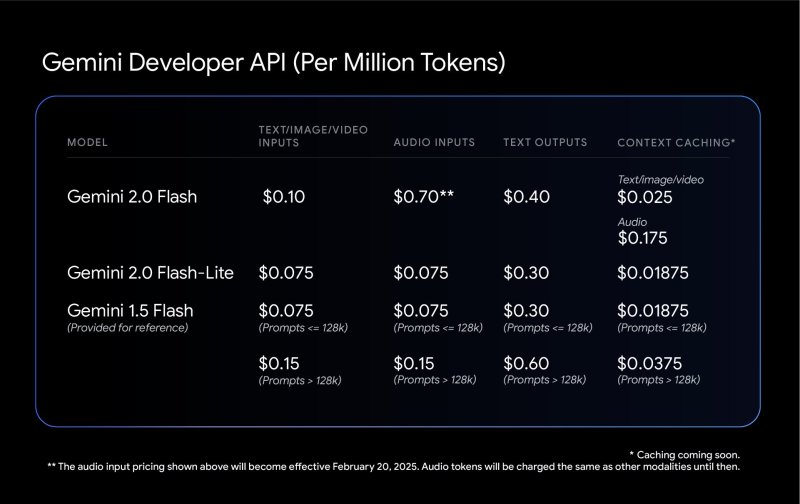

Như được hiển thị trong bảng bên dưới, Gemini 2.0 Flash-Lite có giá 0,075 đô la cho mỗi triệu mã thông báo (đầu vào) và 0,30 đô la cho mỗi triệu mã thông báo (đầu ra). Flash-Lite được định vị là một lựa chọn rất phải chăng cho các nhà phát triển, vượt trội hơn Gemini 1.5 Flash trên hầu hết các điểm chuẩn trong khi vẫn duy trì cùng một cấu trúc chi phí.

Logan Kilpatrick nhấn mạnh tính hợp lý về giá cả và giá trị của các mô hình, nói rằng: “Gemini 2.0 Flash là giá trị tốt nhất của bất kỳ LLM nào, đã đến lúc xây dựng!”

Thật vậy, so với các LLM truyền thống hàng đầu khác có sẵn thông qua API nhà cung cấp như OpenAI 4o-mini </a >(0,15 đô la/0,6 đô la cho mỗi 1 triệu mã thông báo vào/ra), Anthropic Claude</a > (0,8 đô la/4 đô la! cho mỗi 1 triệu vào/ra) và thậm chí cả LLM truyền thống V3 của DeepSeek (0,14 đô la/0,28 đô la), Gemini 2.0 Flash dường như là lựa chọn tốt nhất cho đồng tiền bát gạo.

Gemini 2.0 Pro có mặt trong bản thử nghiệm với cửa sổ ngữ cảnh 2 triệu mã thông báo

Đối với người dùng yêu cầu các khả năng AI nâng cao hơn, mô hình Gemini 2.0 Pro (Thử nghiệm) hiện đã có sẵn để thử nghiệm.

Google DeepMind mô tả đây là mô hình mạnh nhất của mình để thực hiện mã hóa và xử lý các lời nhắc phức tạp. Nó có cửa sổ ngữ cảnh 2 triệu mã thông báo và khả năng lý luận được cải thiện, với khả năng tích hợp các công cụ bên ngoài như Google Search và thực thi mã.

Sam Witteveen, đồng sáng lập và Giám đốc điều hành của Red Dragon AI và là Chuyên gia phát triển Google bên ngoài về Học máy, đã thảo luận về mô hình Pro trong một bài đánh giá trên YouTube. “Mô hình Gemini 2.0 Pro mới có cửa sổ ngữ cảnh hai triệu mã thông báo, hỗ trợ các công cụ, thực thi mã, gọi hàm và kết nối với Google Search — mọi thứ chúng ta có trong Pro 1.5 nhưng đã được cải thiện.”

Ông cũng lưu ý về phương pháp lặp đi lặp lại của Google đối với phát triển AI: “Một trong những điểm khác biệt chính trong chiến lược của Google là họ phát hành các phiên bản thử nghiệm của mô hình trước khi chúng được GA (truy cập chung), cho phép lặp lại nhanh chóng dựa trên phản hồi.”

Các điểm chuẩn hiệu suất tiếp tục minh họa các khả năng của dòng mô hình Gemini 2.0. Ví dụ: Gemini 2.0 Pro vượt trội hơn Flash và Flash-Lite trong các tác vụ như lý luận, hiểu đa ngôn ngữ và xử lý ngữ cảnh dài.

An toàn AI và Phát triển Tương lai

Bên cạnh những cập nhật này, Google DeepMind đang triển khai các biện pháp an toàn và bảo mật mới cho các mô hình Gemini 2.0. Công ty đang sử dụng các kỹ thuật học tăng cường để cải thiện độ chính xác của phản hồi, sử dụng AI để phê bình và tinh chỉnh các đầu ra của chính nó. Ngoài ra, thử nghiệm bảo mật tự động đang được sử dụng để xác định các lỗ hổng, bao gồm cả các mối đe dọa tiêm lời nhắc gián tiếp.

Trong tương lai, Google DeepMind có kế hoạch mở rộng các khả năng của dòng mô hình Gemini 2.0, với các phương thức bổ sung ngoài văn bản dự kiến sẽ có sẵn rộng rãi trong những tháng tới.

Với những cập nhật này, Google đang củng cố nỗ lực của mình vào phát triển AI, cung cấp một loạt các mô hình được thiết kế để mang lại hiệu quả, giá cả phải chăng và giải quyết vấn đề nâng cao, đồng thời đáp lại sự trỗi dậy của DeepSeek với bộ mô hình của riêng mình, từ mạnh mẽ đến rất mạnh mẽ và cực kỳ phải chăng đến ít hơn một chút (nhưng vẫn khá) phải chăng.

Liệu điều đó có đủ để giúp Google thâm nhập vào một phần thị trường AI doanh nghiệp, thị trường đã từng bị OpenAI thống trị và giờ đã bị DeepSeek lật đổ? Chúng tôi sẽ tiếp tục theo dõi và cho bạn biết!

Tìm kiếm tức thì các thông tin tại website: tranxuanloc.com

Mẹo tìm kiếm: "Từ khóa cần tìm kiếm" site:tranxuanloc.com để tìm được kết quả chính xác trên công cụ tìm kiếm của google[wd_asp id=1]