Huấn luyện LLM: Không cần nhiều dữ liệu cho tác vụ suy luận

Nghiên cứu mới: Không cần quá nhiều dữ liệu để huấn luyện LLM cho các tác vụ suy luận

Giới thiệu về huấn luyện LLM với dữ liệu nhỏ

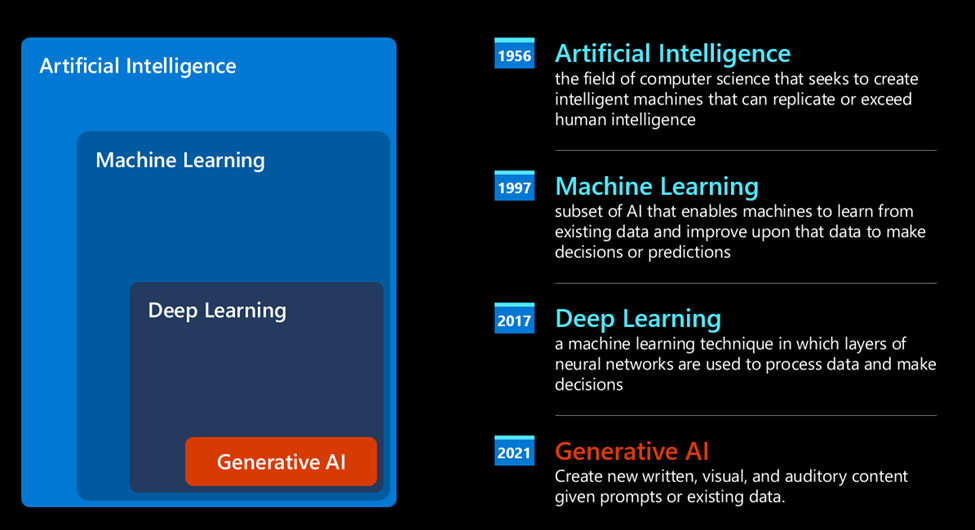

Các nhà nghiên cứu đã phát hiện ra rằng các mô hình ngôn ngữ lớn (LLM) có thể được huấn luyện hiệu quả cho các tác vụ suy luận phức tạp mà không cần dựa vào lượng dữ liệu khổng lồ. Nghiên cứu này mở ra một hướng đi mới, cho thấy rằng chỉ với một tập dữ liệu được tuyển chọn kỹ lưỡng, chúng ta có thể huấn luyện LLM để thực hiện các tác vụ mà trước đây cần hàng chục nghìn mẫu dữ liệu huấn luyện.

Hình ảnh: Venturebeat, qua Ideogram

Hiệu quả đến từ đâu?

Hiệu quả này đến từ kiến thức vốn có mà các LLM hiện đại thu được trong giai đoạn tiền huấn luyện. Các phương pháp huấn luyện mới ngày càng tiết kiệm dữ liệu và tài nguyên tính toán, giúp các doanh nghiệp có thể tạo ra các mô hình tùy chỉnh mà không cần đến nguồn lực của các phòng thí nghiệm AI lớn. Đây là một bước tiến quan trọng, dân chủ hóa quyền truy cập vào công nghệ AI tiên tiến.

LIMO: Ít hơn là nhiều hơn

Nghiên cứu thách thức giả định rằng cần một lượng lớn dữ liệu để huấn luyện LLM cho các tác vụ suy luận. Các nhà nghiên cứu giới thiệu khái niệm “ít hơn là nhiều hơn” (Less is More – LIMO). Công trình của họ dựa trên nghiên cứu trước đây cho thấy LLM có thể được điều chỉnh phù hợp với sở thích của con người chỉ với một vài ví dụ.

Ít hơn là nhiều hơn (LIMO) cho suy luận (nguồn: arXiv)

Trong các thử nghiệm, họ đã chứng minh rằng có thể tạo ra một bộ dữ liệu LIMO cho các tác vụ suy luận toán học phức tạp chỉ với vài trăm ví dụ huấn luyện. Một LLM được tinh chỉnh trên bộ dữ liệu này có thể tạo ra các chuỗi suy luận chuỗi tư duy (CoT) phức tạp, cho phép nó hoàn thành các tác vụ với tỷ lệ thành công rất cao.

Ví dụ, một mô hình Qwen2.5-32B-Instruct được tinh chỉnh trên 817 ví dụ huấn luyện được chọn dựa trên LIMO đã đạt được độ chính xác 57,1% trên tiêu chuẩn AIME đầy thách thức và 94,8% trên MATH, vượt trội hơn các mô hình được huấn luyện trên số lượng ví dụ lớn hơn gấp trăm lần. Nó cũng đạt điểm cao hơn trên các tiêu chuẩn so với các mô hình suy luận như QwQ-32B-Preview (một phiên bản của mô hình Qwen đã được huấn luyện cho suy luận) và OpenAI o1-preview, cả hai đều đã được huấn luyện với dữ liệu lớn hơn và tài nguyên tính toán lớn hơn.

Hơn nữa, các mô hình được huấn luyện bằng LIMO có khả năng khái quát hóa cho các ví dụ khác biệt đáng kể so với dữ liệu huấn luyện của chúng. Ví dụ, trên tiêu chuẩn khoa học OlympiadBench, mô hình LIMO hoạt động tốt hơn QwQ-32B-Preview, và trên tiêu chuẩn GPQA đầy thách thức, nó đạt được độ chính xác 66,7%, gần với điểm số hàng đầu của OpenAI-o1-preview là 73,3%.

Ý nghĩa đối với AI doanh nghiệp

Tùy chỉnh LLM là một trường hợp sử dụng hấp dẫn cho các ứng dụng doanh nghiệp. Nhờ các kỹ thuật như tạo sinh tăng cường truy xuất (RAG) và học trong ngữ cảnh, LLM có thể được tùy chỉnh để sử dụng dữ liệu riêng hoặc thực hiện các tác vụ mới mà không cần tinh chỉnh tốn kém.

Tuy nhiên, các tác vụ suy luận thường yêu cầu huấn luyện và tinh chỉnh LLM. Quan điểm phổ biến là các tác vụ như vậy đòi hỏi khối lượng lớn các ví dụ huấn luyện với các chuỗi suy luận và giải pháp chi tiết. Tạo ra các bộ dữ liệu như vậy là chậm và không thực tế đối với nhiều ứng dụng và công ty.

Gần đây hơn, các nhà nghiên cứu đã chỉ ra rằng các phương pháp học tăng cường thuần túy có thể cho phép các mô hình tự huấn luyện cho các tác vụ suy luận bằng cách tạo ra nhiều giải pháp và chọn ra những giải pháp hoạt động tốt nhất. Mặc dù phương pháp này đòi hỏi ít nỗ lực thủ công hơn, nhưng nó vẫn đòi hỏi các tài nguyên tính toán đắt tiền, vượt quá khả năng của nhiều doanh nghiệp.

Mặt khác, việc tạo ra vài trăm ví dụ là một nỗ lực mà nhiều công ty có thể thực hiện, đưa các mô hình suy luận chuyên dụng đến gần hơn với nhiều tổ chức hơn.

“Khám phá này có ý nghĩa sâu sắc đối với nghiên cứu trí tuệ nhân tạo: Nó cho thấy rằng ngay cả khả năng suy luận phức tạp ở cấp độ cạnh tranh cũng có thể được gợi ra một cách hiệu quả thông qua các mẫu huấn luyện tối thiểu nhưng được tuyển chọn,” các nhà nghiên cứu viết.

Tại sao LIMO hoạt động?

Trong các thử nghiệm, các nhà nghiên cứu xác định hai lý do chính tại sao LLM có thể học các tác vụ suy luận phức tạp với ít ví dụ hơn.

Thứ nhất, các mô hình nền tảng hiện đại đã được huấn luyện trên một lượng rất lớn nội dung và mã toán học trong quá trình tiền huấn luyện. Điều này có nghĩa là các LLM này đã sở hữu kiến thức suy luận phong phú trong các tham số của chúng, có thể được kích hoạt thông qua các ví dụ được tạo ra cẩn thận.

Thứ hai, các kỹ thuật hậu huấn luyện mới đã chỉ ra rằng việc cho phép các mô hình tạo ra các chuỗi suy luận mở rộng sẽ cải thiện đáng kể khả năng suy luận của chúng. Về bản chất, việc cho các mô hình thêm thời gian để “suy nghĩ” cho phép chúng giải nén và áp dụng kiến thức đã được huấn luyện trước đó một cách hiệu quả hơn.

“Chúng tôi đưa ra giả thuyết rằng suy luận thành công xuất phát từ sự hiệp lực của hai yếu tố này: kiến thức được huấn luyện trước phong phú và tài nguyên tính toán đầy đủ tại thời điểm suy luận,” các nhà nghiên cứu viết. “Những phát triển này cùng nhau gợi ý một khả năng nổi bật: Nếu các mô hình sở hữu kiến thức suy luận phong phú và được cung cấp không gian tính toán đầy đủ, thì việc kích hoạt khả năng suy luận của chúng có thể chỉ yêu cầu một số lượng nhỏ các mẫu huấn luyện chất lượng cao khuyến khích sự cân nhắc mở rộng, thay vì các bộ dữ liệu tinh chỉnh khổng lồ.”

Việc chọn các vấn đề phức tạp hơn để đưa vào bộ dữ liệu huấn luyện có thể có ảnh hưởng đáng kể đến độ chính xác của mô hình được huấn luyện trong các tác vụ suy luận (nguồn: arXiv)

Theo các phát hiện của các nhà nghiên cứu, việc tạo ra các bộ dữ liệu LIMO hữu ích phụ thuộc vào việc chọn đúng vấn đề và giải pháp. Những người quản lý dữ liệu nên ưu tiên các vấn đề thách thức đòi hỏi các chuỗi suy luận phức tạp, các quá trình tư duy đa dạng và tích hợp kiến thức. Các vấn đề cũng nên khác biệt so với phân phối huấn luyện của mô hình để khuyến khích các phương pháp suy luận mới và buộc nó hướng tới khái quát hóa.

Theo đó, các giải pháp nên rõ ràng và được tổ chức tốt, với các bước suy luận được điều chỉnh cho phù hợp với độ phức tạp của vấn đề. Các giải pháp chất lượng cao cũng nên cung cấp hỗ trợ giáo dục chiến lược bằng cách dần dần xây dựng sự hiểu biết thông qua các giải thích được cấu trúc cẩn thận.

“Bằng cách tập trung vào một tập hợp tối thiểu nhưng được tuyển chọn tỉ mỉ các chuỗi suy luận, chúng tôi thể hiện nguyên tắc cốt lõi của LIMO: Các bản trình diễn chất lượng cao, chứ không phải khối lượng dữ liệu đơn thuần, là chìa khóa để mở khóa các khả năng suy luận phức tạp,” các nhà nghiên cứu viết.

Các nhà nghiên cứu đã phát hành mã và dữ liệu được sử dụng để huấn luyện các mô hình LIMO trong các thử nghiệm của họ. Trong tương lai, họ có kế hoạch mở rộng khái niệm này sang các lĩnh vực và ứng dụng khác.

Kết luận: Tương lai của huấn luyện LLM

Nghiên cứu này mở ra một kỷ nguyên mới cho việc huấn luyện LLM, cho phép các doanh nghiệp và cá nhân tạo ra các mô hình suy luận mạnh mẽ với chi phí thấp hơn và hiệu quả hơn. Việc tập trung vào chất lượng hơn số lượng dữ liệu có thể cách mạng hóa cách chúng ta tiếp cận AI, mở ra nhiều cơ hội cho các ứng dụng và đổi mới trong tương lai.

Các từ khóa liên quan:

- Huấn luyện LLM

- Suy luận AI

- Dữ liệu nhỏ

- LIMO

- Mô hình ngôn ngữ lớn

- Học máy

- Trí tuệ nhân tạo

- Tinh chỉnh mô hình

Ứng dụng tiềm năng:

- Phát triển các mô hình AI chuyên dụng cho các ngành công nghiệp cụ thể.

- Cải thiện khả năng suy luận của trợ lý ảo và chatbot.

- Tạo ra các công cụ giáo dục thông minh và cá nhân hóa.

- Hỗ trợ nghiên cứu khoa học và khám phá các giải pháp mới.

Bạn có thấy hữu ích không? Hãy cho chúng tôi +1 nhé

Tìm kiếm tức thì các thông tin tại website: tranxuanloc.com

Mẹo tìm kiếm: "Từ khóa cần tìm kiếm" site:tranxuanloc.com để tìm được kết quả chính xác trên công cụ tìm kiếm của googleGỢI Ý: Khóa học sales OTAOTA là gìđăng ký kênh OTAEmail theo tên miềnCRMWP Content Crawlerchuyển VPSACF