LangChain chỉ ra rằng các AI agent vẫn chưa đạt đến trình độ con người vì chúng bị choáng ngợp bởi các công cụ

Một robot do AI tạo ra đang ngồi trước máy tính, trả lời các yêu cầu dịch vụ khách hàng.

Ngay sau khi các AI agent cho thấy tiềm năng, các tổ chức đã phải vật lộn để tìm ra liệu một agent duy nhất có đủ hay không, hoặc liệu họ nên đầu tư vào việc xây dựng một mạng lưới đa agent rộng lớn hơn, tiếp cận nhiều điểm hơn trong tổ chức của họ.

Công ty framework điều phối LangChain đã tìm cách tiếp cận gần hơn với câu trả lời cho câu hỏi này. Họ đã thực hiện một số thử nghiệm trên một AI agent và nhận thấy rằng các agent đơn lẻ có một giới hạn về ngữ cảnh và công cụ trước khi hiệu suất của chúng bắt đầu giảm sút. Những thử nghiệm này có thể dẫn đến sự hiểu biết tốt hơn về kiến trúc cần thiết để duy trì các agent và hệ thống đa agent.

Trong một bài đăng trên blog, LangChain đã trình bày chi tiết một loạt các thử nghiệm mà họ đã thực hiện với một ReAct agent duy nhất và đánh giá hiệu suất của nó. Câu hỏi chính mà LangChain hy vọng trả lời là: “Tại thời điểm nào thì một ReAct agent duy nhất trở nên quá tải với các hướng dẫn và công cụ, và sau đó chứng kiến hiệu suất giảm?”

LangChain đã chọn sử dụng framework ReAct agent vì nó là “một trong những kiến trúc agent cơ bản nhất.”

Mặc dù việc đánh giá hiệu suất của agent thường có thể dẫn đến kết quả gây hiểu lầm, LangChain đã chọn giới hạn thử nghiệm ở hai nhiệm vụ dễ định lượng của một agent: trả lời câu hỏi và lên lịch cuộc họp.

LangChain viết: “Có rất nhiều điểm chuẩn hiện có cho việc sử dụng công cụ và gọi công cụ, nhưng đối với mục đích của thử nghiệm này, chúng tôi muốn đánh giá một agent thực tế mà chúng tôi thực sự sử dụng. “Agent này là trợ lý email nội bộ của chúng tôi, chịu trách nhiệm cho hai lĩnh vực công việc chính – trả lời và lên lịch các yêu cầu cuộc họp và hỗ trợ khách hàng với các câu hỏi của họ.”

Các thông số của thử nghiệm LangChain

LangChain chủ yếu sử dụng các ReAct agent dựng sẵn thông qua nền tảng LangGraph của mình. Các agent này có các mô hình ngôn ngữ lớn (LLM) gọi công cụ, trở thành một phần của bài kiểm tra điểm chuẩn. Các LLM này bao gồm Claude 3.5 Sonnet của Anthropic, Llama-3.3-70B của Meta và bộ ba mô hình từ OpenAI, GPT-4o, o1 và o3-mini.

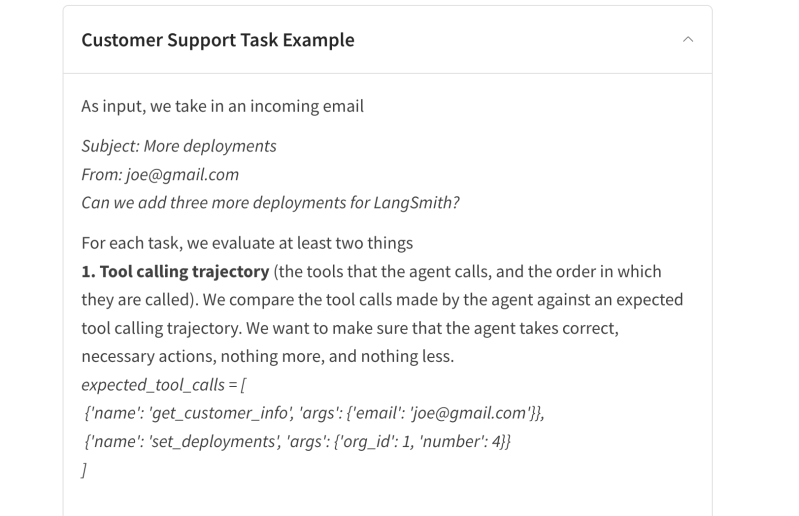

Công ty đã chia nhỏ quá trình thử nghiệm để đánh giá tốt hơn hiệu suất của trợ lý email đối với hai nhiệm vụ, tạo ra một danh sách các bước để nó tuân theo. Nó bắt đầu với khả năng hỗ trợ khách hàng của trợ lý email, xem xét cách agent chấp nhận email từ khách hàng và trả lời bằng một câu trả lời.

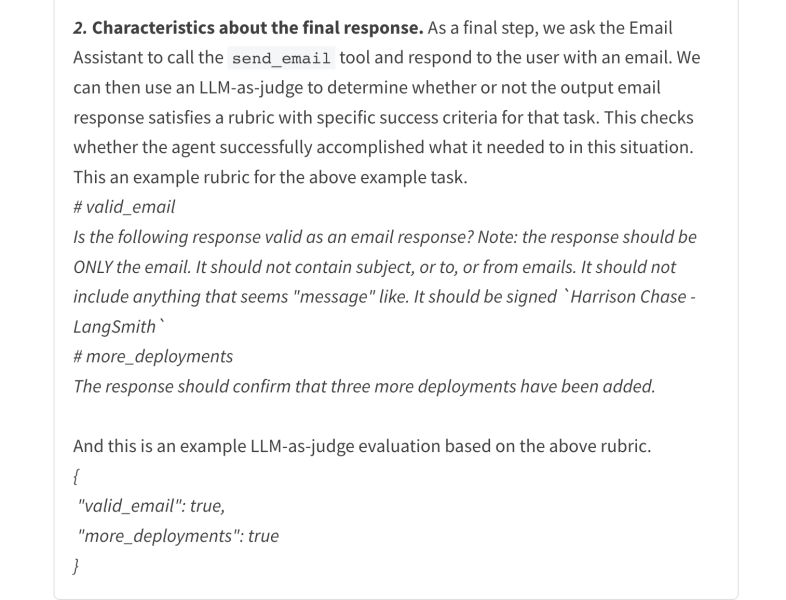

LangChain đầu tiên đánh giá quỹ đạo gọi công cụ, hoặc các công cụ mà một agent khai thác. Nếu agent tuân theo đúng thứ tự, nó sẽ vượt qua bài kiểm tra. Tiếp theo, các nhà nghiên cứu yêu cầu trợ lý trả lời một email và sử dụng LLM để đánh giá hiệu suất của nó.

Đối với lĩnh vực công việc thứ hai, lên lịch lịch, LangChain tập trung vào khả năng tuân theo hướng dẫn của agent.

Các nhà nghiên cứu viết: “Nói cách khác, agent cần ghi nhớ các hướng dẫn cụ thể được cung cấp, chẳng hạn như chính xác thời điểm nó nên lên lịch các cuộc họp với các bên khác nhau.

Làm quá tải agent

Sau khi xác định các thông số, LangChain bắt đầu gây căng thẳng và áp đảo agent trợ lý email.

Nó đặt 30 nhiệm vụ cho mỗi nhiệm vụ lên lịch lịch và hỗ trợ khách hàng. Chúng được chạy ba lần (tổng cộng 90 lần chạy). Các nhà nghiên cứu đã tạo ra một agent lên lịch lịch và một agent hỗ trợ khách hàng để đánh giá tốt hơn các nhiệm vụ.

LangChain giải thích: “Agent lên lịch lịch chỉ có quyền truy cập vào lĩnh vực lên lịch lịch và agent hỗ trợ khách hàng chỉ có quyền truy cập vào lĩnh vực hỗ trợ khách hàng.

Sau đó, các nhà nghiên cứu đã thêm nhiều nhiệm vụ và công cụ miền hơn vào các agent để tăng số lượng trách nhiệm. Chúng có thể bao gồm từ nguồn nhân lực, đến đảm bảo chất lượng kỹ thuật, đến pháp lý và tuân thủ và một loạt các lĩnh vực khác.

Suy giảm hướng dẫn của agent đơn lẻ

Sau khi chạy các đánh giá, LangChain nhận thấy rằng các agent đơn lẻ thường trở nên quá tải khi được yêu cầu làm quá nhiều việc. Chúng bắt đầu quên gọi các công cụ hoặc không thể phản hồi các tác vụ khi được cung cấp thêm hướng dẫn và ngữ cảnh.

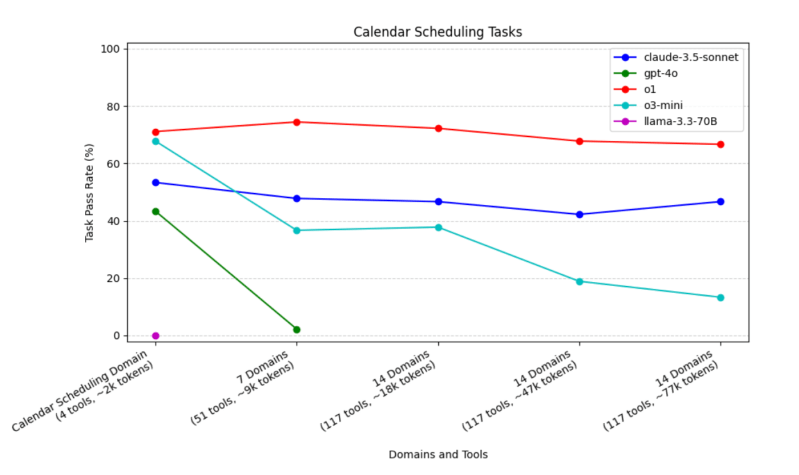

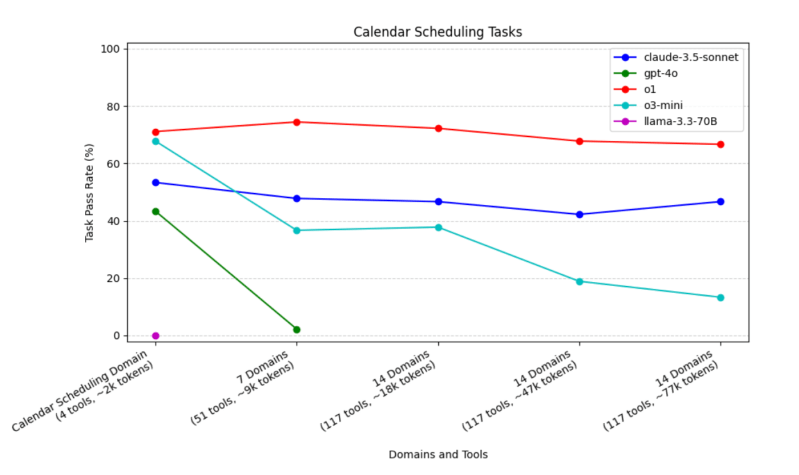

LangChain nhận thấy rằng các agent lên lịch lịch sử dụng GPT-4o “hoạt động kém hơn Claude-3.5-sonnet, o1 và o3 trên các kích thước ngữ cảnh khác nhau và hiệu suất giảm mạnh hơn so với các mô hình khác khi ngữ cảnh lớn hơn được cung cấp.” Hiệu suất của các trình lên lịch lịch GPT-4o giảm xuống 2% khi các miền tăng lên ít nhất bảy.

Các mô hình khác cũng không khá hơn nhiều. Llama-3.3-70B quên gọi công cụ send_email, “vì vậy nó đã thất bại trong mọi trường hợp thử nghiệm.”

Chỉ Claude-3.5-sonnet, o1 và o3-mini đều nhớ gọi công cụ, nhưng Claude-3.5-sonnet hoạt động kém hơn hai mô hình OpenAI còn lại. Tuy nhiên, hiệu suất của o3-mini giảm khi các miền không liên quan được thêm vào hướng dẫn lên lịch.

Agent hỗ trợ khách hàng có thể gọi nhiều công cụ hơn, nhưng đối với thử nghiệm này, LangChain cho biết Claude-3.5-mini hoạt động tốt như o3-mini và o1. Nó cũng cho thấy sự sụt giảm hiệu suất nông hơn khi có thêm các miền. Tuy nhiên, khi cửa sổ ngữ cảnh mở rộng, mô hình Claude hoạt động kém hơn.

GPT-4o cũng hoạt động kém nhất trong số các mô hình được thử nghiệm.

LangChain lưu ý: “Chúng tôi thấy rằng khi có thêm ngữ cảnh được cung cấp, việc tuân theo hướng dẫn trở nên tồi tệ hơn. Một số nhiệm vụ của chúng tôi được thiết kế để tuân theo các hướng dẫn cụ thể (ví dụ: không thực hiện một hành động nhất định cho khách hàng có trụ sở tại EU). “Chúng tôi nhận thấy rằng những hướng dẫn này sẽ được các agent tuân theo thành công với ít miền hơn, nhưng khi số lượng miền tăng lên, những hướng dẫn này thường bị quên và các nhiệm vụ sau đó không thành công.”

Công ty cho biết họ đang khám phá cách đánh giá kiến trúc đa agent bằng phương pháp quá tải miền tương tự.

LangChain đã đầu tư vào hiệu suất của các agent, vì nó đã giới thiệu khái niệm về “các agent xung quanh”, hoặc các agent chạy trong nền và được kích hoạt bởi các sự kiện cụ thể. Những thử nghiệm này có thể giúp bạn dễ dàng tìm ra cách tốt nhất để đảm bảo hiệu suất của agent.

Tìm kiếm tức thì các thông tin tại website: tranxuanloc.com

Mẹo tìm kiếm: "Từ khóa cần tìm kiếm" site:tranxuanloc.com để tìm được kết quả chính xác trên công cụ tìm kiếm của google[wd_asp id=1]